[导读]:前期网站做了调整,url缩短到了3个目录层级,之前的url全部就成了死链,但是也有很多没收录的,前段时间我把全站的死链都提交了,也禁止了抓取,站内的死链也和奇葩的i...

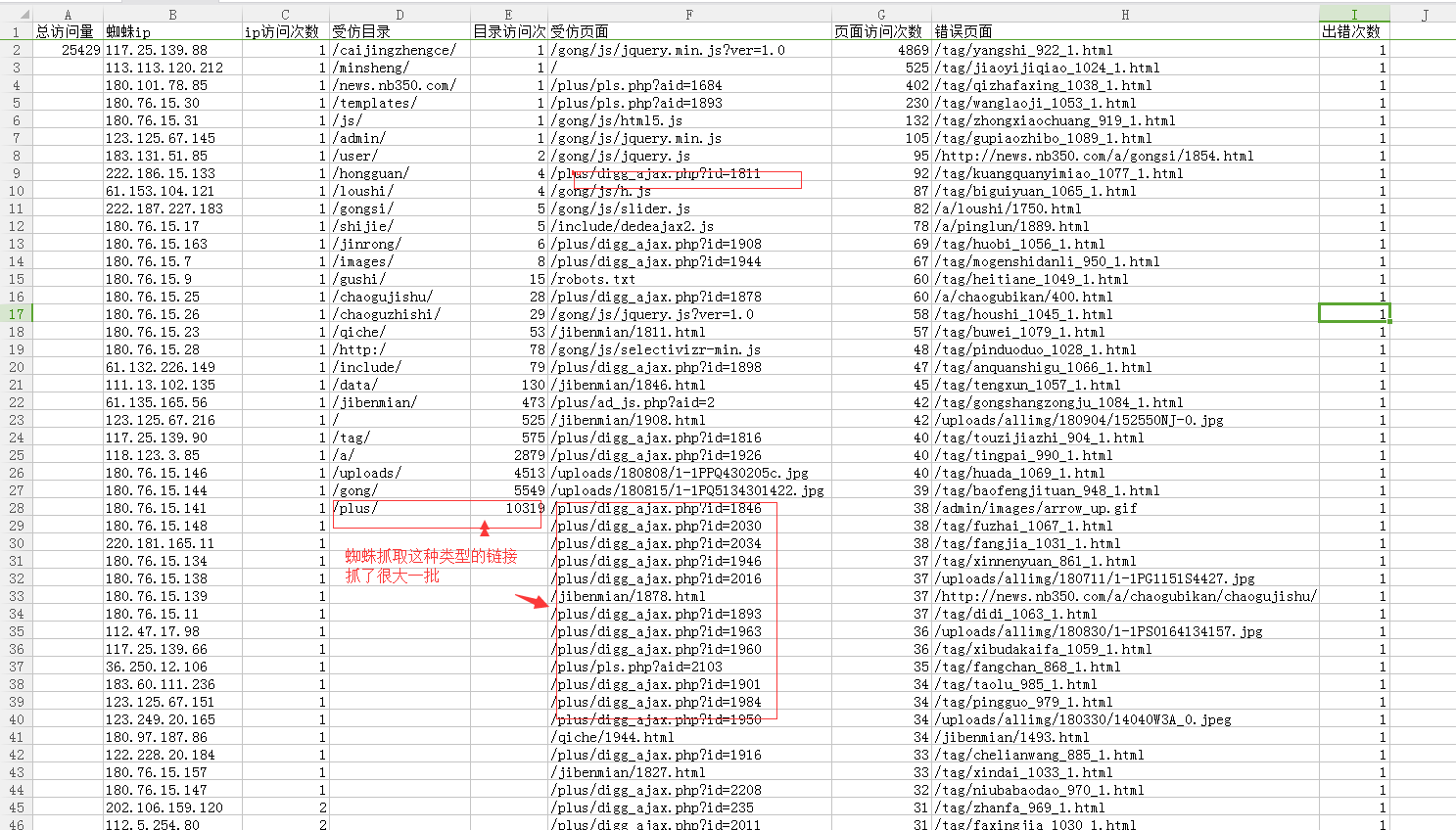

前期网站做了调整,url缩短到了3个目录层级,之前的url全部就成了死链,但是也有很多没收录的,前段时间我把全站的死链都提交了,也禁止了抓取,站内的死链也和奇葩的id链接也都删除了,可以好几天过去了,百度蜘蛛依然正常的抓取以前的页面,反而我现在发布的新文章一直不收录,也难得去抓取,现在的蜘蛛日记搞得我看到就烦,有什么更好的办法让禁止蜘蛛抓取吗?

你不想让他抓取的,在Robots,txt里面禁止抓取。

不用管。做好404就可以

###百度垃圾

###大型平台死链处理经验:

1、404必须做;

2、让死链入口消失;

3、整个栏目删除的Robots指定屏蔽蜘蛛;

4、通过指令找到收录的死链,生成文本站长平台提交死链(这个对于大型平台作用不大,小网站建议使用)。

5、删除前先通过抓取工具抓取要删除或修改的链接,删除后直接提交站长平台。

###做个Robots文件吧不想让蜘蛛爬行的路径做一下规则,robots可以在站长平台编辑,做好上传到网站根目录就行了,多到站长论坛发发外链。

###要管的,蜘蛛爬取一个网站的页面是有限的,抓取的垃圾网页多了,就浪费了自身优质网页的名额了,

做个Robots文件吧

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/89607.html