[导读]:比如这个templets文件夹我已经禁止了,但是查看网站日志,发现蜘蛛还是去抓了,而且还是提示404 这是咋回事? 难道说robots文件没用吗? 应该抓一段时间就不会再爬了 ### 还是看...

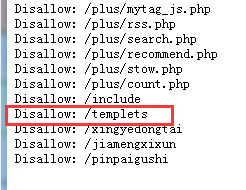

比如这个templets文件夹我已经禁止了,但是查看网站日志,发现蜘蛛还是去抓了,而且还是提示404

这是咋回事?

难道说robots文件没用吗?

应该抓一段时间就不会再爬了

###还是看蜘蛛心情

###Robots文件不是绝对禁止不抓取和抓取的,它只是告诉搜索引擎你不想抓取的目录,关键还是看它自己要不要抓取。

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/88783.html