网站的URL是从/1.html到/10,000.html

如果我希望/1.html到/5,000.html禁止收录,而/5,001.html到/10,000.html不受影响。

请问如何用Robots来实现这个效果?

--------------------------------------补充----------------------------------------------

之前没想写太多,不过有人问了,就说一下为什么要屏蔽1.html到5000.html。

出于某种原因的 考虑,1.html-5000.html每个URL对应的页面有多个URL。

这1.html-5000.html也是不想让用户访问的。

所以,想屏蔽这5000个URL。

在robots中没有方法可以实现按数字大小的规则禁止收录吗?

考虑把1-5000和5001-10000放到两个文件夹中。屏蔽文件夹。

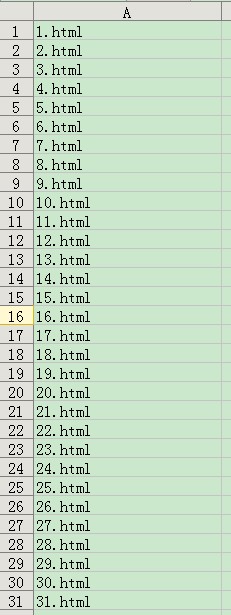

###用excel生成一个列表,然后写入Robots.txt

###

人的一生最宝贵的是真诚的朋友,让我们的友情烘托着灿烂的朝阳,在生命的海浪上闪耀出眩目的光芒

###可以借鉴 学习

###能不能够利用程序自动在所有出现“URL是从/到/”的这些链接的地方加上Nofollow标签?

单纯Robots.txt掉的话,那些“URL是从/到/”的页面上还有“URL是从/到/”的页面上的链接,robots了也无效的吧。

这一万页面就真的都是统一的目录或者URL结构么?

Disallow: Disallow: Disallow: ...

Disallow: 5.html

Disallow: 4.html

Disallow: 3.html

Disallow: 2.html

Disallow: 1*.html

类似、拉列表吧——这样也不少啊。

URL结构没差别的话,所属页面是否可以增加Nofollow?

将1到5000网页改到目录a

再使用正则表达式301重定向到目录a

然后设置Robots.txt

Disallow: /a/

这么多的页面链接要禁止收录

为什么?文章页面要这么多屏蔽 是什么原因导致你要屏蔽 要搞清楚这个

一般的文章页面 不可能也没有理由去屏蔽这么多类似的文章页面

可以通过其他方法来处理

@陈红然 大哥的方法简单易用。直接excel拉个列。不过拉了5000个数量也比较麻烦。当然也可以简单的写个c语言if不断的输出,然后保存的txt里面。 文件夹的形式个人感觉从网站结构上行不通~~~

###有个办法,也是有点麻烦,就是为了1到5000的页面利用META元标签单独设置Robots访问规则。上面楼主说的“考虑把1-5000和5001-10000放到两个文件夹中。屏蔽文件夹。”方法挺简单的。

###你们在说神马?看不懂。你们也不说的更明白一点。

陈红然,以后再问这种问题,能不能讲明白为什么这么做?

普及一下我们这些小白。

服了你了。问这么看不懂的问题。也不说明白为什么。

还有回答的人,怎么操作,能不能讲的细节一点。。。

都是一群什么人那。

这世道。

哎。。

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/85741.html