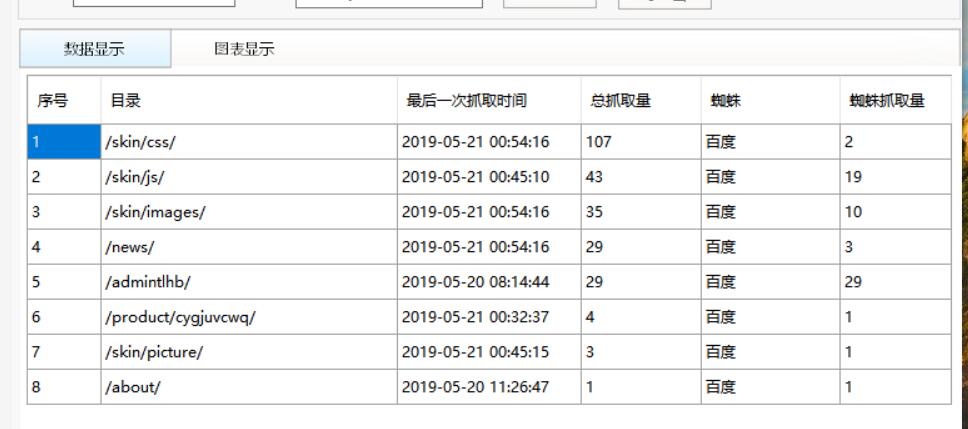

大神们帮我看看 我这个robots文件规则写错了,怎么禁止了,网站日志显示百度蜘蛛还在抓取admintlhb这个目录??

然后这个我是不是要禁止一下skin这个目录

这个不用管,百度就是这样 任何一个网站也都这样

###应该是假蜘蛛抓取的。有很多百度假蜘蛛。

###蜘蛛还是会抓的,屏蔽也不一定管用

###首先说3点。

1、首先要手动判定下是真百度蜘蛛还是假百度蜘蛛

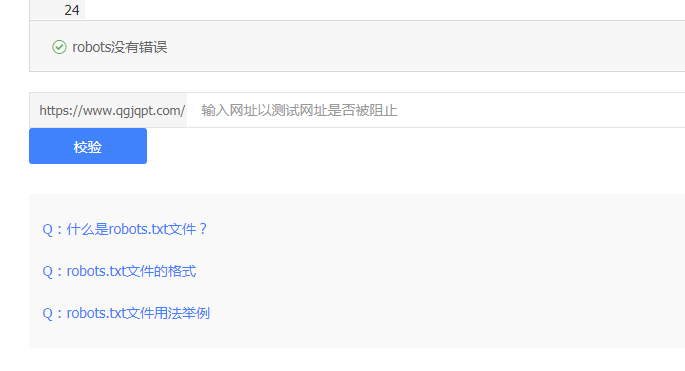

2、去百度资源搜索平台→Robots有个校验,去测试下,是否拒绝访问

3、Disallow:/admintlhb 这样写,如果后面加斜线,表示允许抓取admintlhb文件,但是不允许抓取文件夹下的内容。去掉斜线,表示不允许抓取/admintlhb文件及文件夹下的文件

###其实从现在来看,Robots文件蜘蛛也并没有完全遵守,另外就是robots文件生效期也有大概一个月左右

###大家都说的很对

###禁止了的话还是会被抓取的,Robots生效是需要时间的,需要过渡一段时间

###Robots协议,百度不太会遵守的。

###要禁止后面不能加/,加/就是允许,大哥。每次更改了Robots检测一下

###把skin也禁止了吧,蜘蛛爬你这个目录没任何作用和好处,然后就是Robots一般来说如果禁止了蜘蛛还在抓,那么就不用管他了,每天观察蜘蛛就行了

###Robots协议百度的生效周期是一个月,放上去然后等就行,多注意观察就行。

###确实不用管。禁止只是一个命令而已,不保证蜘蛛还是不是还会抓取。

Robots生效周期是一个月,放上去然后等就行,多注意观察,另外如果你这个是后台地址,不建议你直接写上去

###Robots生效是需要时间的,你是不是在百度抓取之后才禁止收录的admintlhb这个目录,如果是的话,很长一段时间百度还是会抓取这个目录的,生效时间一般一个月左右。

###这个是不管用的,禁不住蜘蛛,淘宝还把百度给屏蔽了,百度不照样抓取淘宝

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/67749.html