网站日志蜘蛛爬取不正常是怎么回事?(悬赏3元)

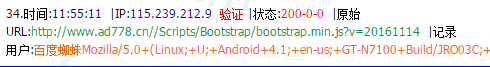

[导读]:网址:http://www.ad778.cn/ [?] ,我的robots禁止了css、scripts等目录,为什么蜘蛛还在爬取呢? 而且蜘蛛爬取的很多内页都是404,类似这种: http://www.ad778.cn/Error/Error404?aspxerrorpath=/...

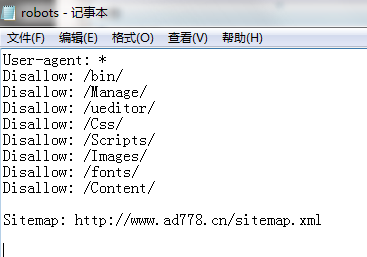

网址:http://www.ad778.cn/[?] ,我的robots禁止了css、scripts等目录,为什么蜘蛛还在爬取呢?

而且蜘蛛爬取的很多内页都是404,类似这种:

http://www.ad778.cn/Error/Error404?aspxerrorpath=/Case/Category/successcase/lastestcase.html[?]

第一,确保Disallow后面的冒号和空格是英文状态下的。

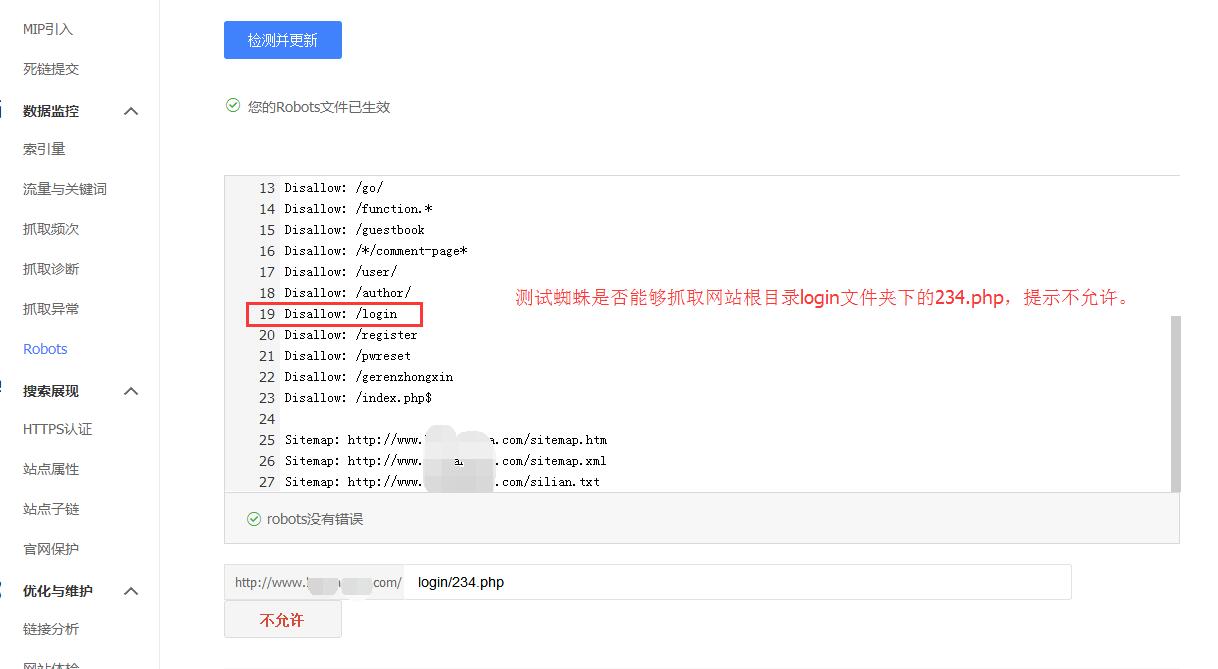

第二,Disallow: 后面的第一条斜杠/是指根目录,你提供的url是,看见没,Scripts

前面有两条斜杠,检查一下你的Scripts是否在更目录里面。正确的规则应该写成/*Scripts

第三,Robots规则是字母区分大小写,如果你更目下的文件夹是小写字母,你在robots写成大写的,也是不行的

第四,建议你加上一条Disallow: /*?* 禁止抓取任何动态页面,你看你的错误页面都是动态的,有了这个,凡是有?号的url都不会抓取。但是前提是你网站要先伪静态化,不然也会禁止抓取你的信息页面

Robots只是使蜘蛛讨厌而已

###因为Robots 有时候即使禁止i了,只要是内容好一样抓取的,这个是你无法左右的

###disaollow: /css/

disaollow: /JS/

###把你那些死链做个txt放到根目录 然后在百度上在提交下就好了 !

###蜘蛛抓的页面是404说明你网站内部页面有些打不开,你用死链工具检查一下网站,看看哪些页面是死链,然后把这些页面该修改修改,该删除删除就好了。

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/49797.html