[导读]:如上图,网站地址是:www.yinghuiyun.com,我很早就把这个路径禁止蜘蛛爬行了,但是蜘蛛一直在造访,不知道为什么呢,求前辈指点! 正常,禁止不完的 ### Disallow:/uploads/ 建议用...

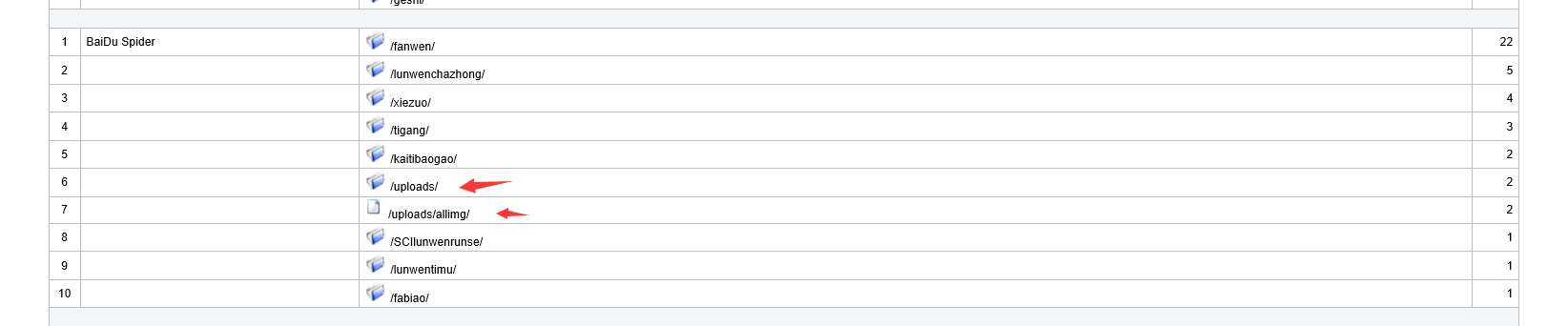

如上图,网站地址是:www.yinghuiyun.com,我很早就把这个路径禁止蜘蛛爬行了,但是蜘蛛一直在造访,不知道为什么呢,求前辈指点!

如上图,网站地址是:www.yinghuiyun.com,我很早就把这个路径禁止蜘蛛爬行了,但是蜘蛛一直在造访,不知道为什么呢,求前辈指点!

正常,禁止不完的

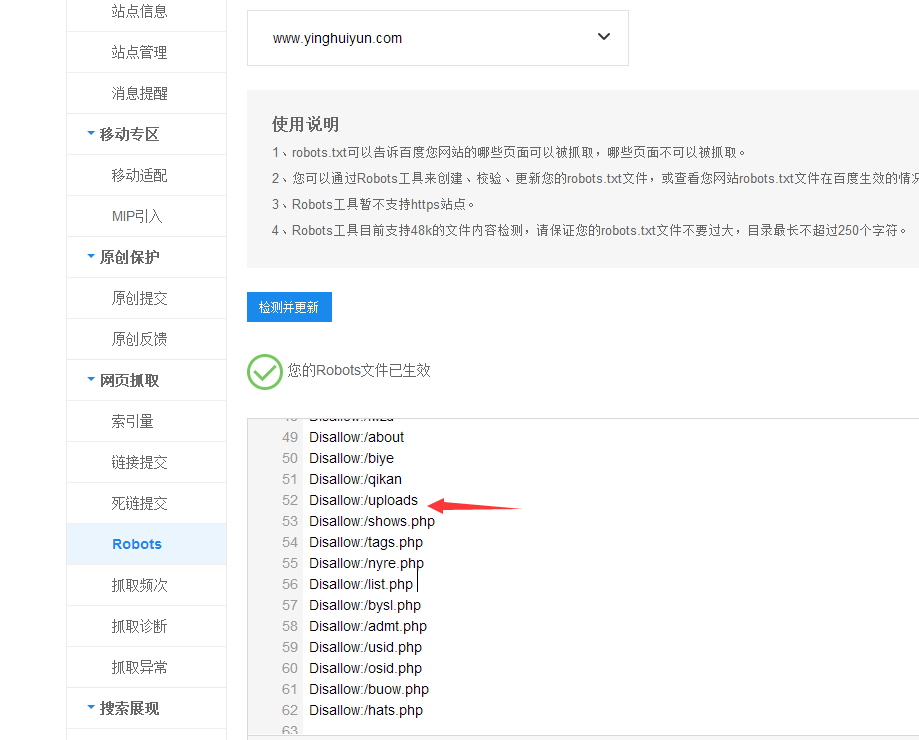

###Disallow:/uploads/ 建议用这个 居于根目录下的uploads目录 阻止蜘蛛爬取

###后面漏了斜杠,加上就可以~

Disallow:uploads/

###Robots协议不会百分之百执行,只要影响不大就行。如果实在不放心效验下你的路径看是否被阻止:如图

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/47344.html