![X~}E3BSH[HJ{B~S)]LZG$01](https://www.vm7.com/uploads/allimg/200303/773ed53b091d0dff988fe0bfea9ef7f8.png)

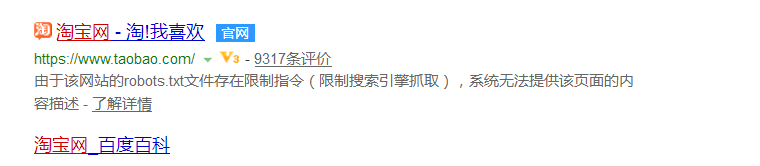

百度对淘宝的内容不抓取,但是有收录。通过什么方式收录的?

存在必然合理,我也想做到这样,对此有什么建议吗?

无须大惊小怪。

这种手法早在多年前就已经有很多灰色行业在使用。

屏蔽百度的目的,如果说是淘宝屏蔽百度,是为了不让百度抓取核心的数据(毕竟曾经是对手)

除了正规站屏蔽以外,还可以参考今日头条等 因为百度打压,所以直接不给百度获取了。*(属于生气型,你打击我 我就不让你抓了,有你没你是一个样,靠的是直接访问)

最后,百度查找一下图片上的关键词 翻到第二页,这是曾经做到首页的站,只是现在没人维护了而已

至于说,Robots屏蔽为什么还被抓取,很简单一个道理,先说热门的。

百度有百度HI,有百度浏览器,但是你在搜索360浏览器的时候,搜索QQ的时候,依然会优先下载,而不是恶意竞争。当然,目前百度的做法是通过百度自身的软件中心网址,来提供下载(说白了就是流量劫持),但是在这个之后,百分之百是官网。如:苹果 排名第一的是苹果手机的官网,是因为绝大部分用户在搜索的时候,需要一个正确有用的结果,如果搜索360浏览器,每次下载出来都是百度浏览器,那么百度就会被淘汰。

再说一下冷门行业,冷门行业为什么屏蔽还会被抓取?具体原理因为我不是工程师,也不是所谓的专家,我只说一个原理,回到最原始的百度,百度里是没有人搜索SEO的,最开始没有这个概念,当第一个SEO的网站出现时,百度一定会发现他,并且返回结果。即使你屏蔽也是一样。很多灰色行业的robots屏蔽 首先目的是为了欺骗百度(避免建立快照,而受到处罚),第二,因为关键词没多少人做,百度要给出更多的结果,来让用户选择,最后再根据首页排名站点的浏览行为,判断谁应该继续留在首页。

###第一,查一下robot.txt有没有给百度蜘蛛爬行的权限,第二,网站有没有做Sitemap,没有赶紧做,第三,检查文件和代码放置的位置正确了没有,

###曾经淘宝是禁止百度抓取和收录内容页面的,如今淘宝部分开放百度蜘蛛,这也意味着百度可以遵循ORobots协议

###禁止搜索引擎抓取的前提是搜索引擎爬取到对应的网站下的Robots.txt文件,在这个过程中,已经入库了部分页面,通常是首页。

另外,通过外部发布的链接也会被爬取并收录,在遵守robots协议的前提下,网站首页是会保留的,不会完全不收录,至于展现的形式就跟正常网站不同,如图片中提示的。

淘宝只是禁止抓取而已,但是百度依然会抓取,还有店主可能对这个店铺做了外链引导蜘蛛抓取,收录很正常。

###即使禁止了百度蜘蛛的访问和爬取,百度还是会进行收录和爬取的。

有时候是禁止不了的

###(1)淘宝并没有写错。 (2)百度有时候的确会不遵守规则,是因为用户体验,包括其他搜索引擎也是如此。 请认真看我之前写的:淘宝网为什么禁止百度蜘蛛爬虫?原文链接(作者:江西SEO曾庆平):

###淘宝Robots协议只限制了百度蜘蛛对其抓取 没有限制其他搜索爬虫。但是由于淘宝属于知名网站 虽然限制了 但百度还是给了一个口子

因为如果用户用百度搜索不到淘宝这么知名的网站,那他会怎么看待这个搜索引擎?

再说回来 当初百度搞自己的商城百度有啊 马云让屏蔽抓取其实是有目的地 他可能想让大家不通过百度这种习惯找淘宝吧

###可以理解为伪收录

(如图,淘宝的Robots.txt屏蔽百度蜘蛛,理论上不该出现在搜索结果里,但是毕竟淘宝是国内电商巨头,这中间可能和百度有某种协议,出现首页结果是对用户搜索习惯的某种妥协,值得注意的是,虽然出现在百度的搜索结果中,但是点击“百度快照”是无效的,百度并未真正收录页面,只是提供了一个“入口”)

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/47164.html