[导读]:网站之前还没搞好就被上线,接手后就先屏蔽了百度蜘蛛,之后处理网站存在的问题以及填充内容,一切都搞定后,上周解除了robots文件的屏蔽,可是到现在为止,一直提示“...

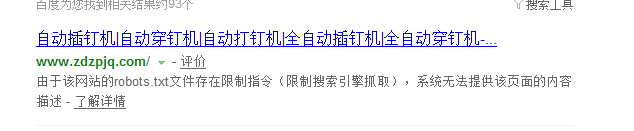

网站之前还没搞好就被上线,接手后就先屏蔽了百度蜘蛛,之后处理网站存在的问题以及填充内容,一切都搞定后,上周解除了robots文件的屏蔽,可是到现在为止,一直提示“由于该网站的robots.txt文件存在限制指令(限制搜索引擎抓取),系统无法提供该页面的内容描述”

地址如下:www.zdzpjq.com

上周五我看还是提示这样,就干脆连robots文件都给删除了,可是依然提示这个。

而且利用百度站长工具, robots检测时 是没有问题的 提示已经允许

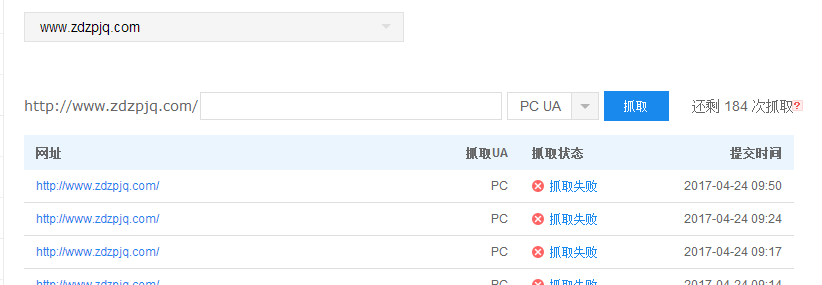

可是利用抓取检测工具 就会提示检测失败

这是啥情况?有知道的吗

如果Robots封禁了,蜘蛛对这个状态是一个星期左右更新一次。

也就说你就算解封了,刷新也没问题了,但蜘蛛还是会滞留大概一个星期。

也有一说是每周四更新

我的也是这样 3天了

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/46946.html