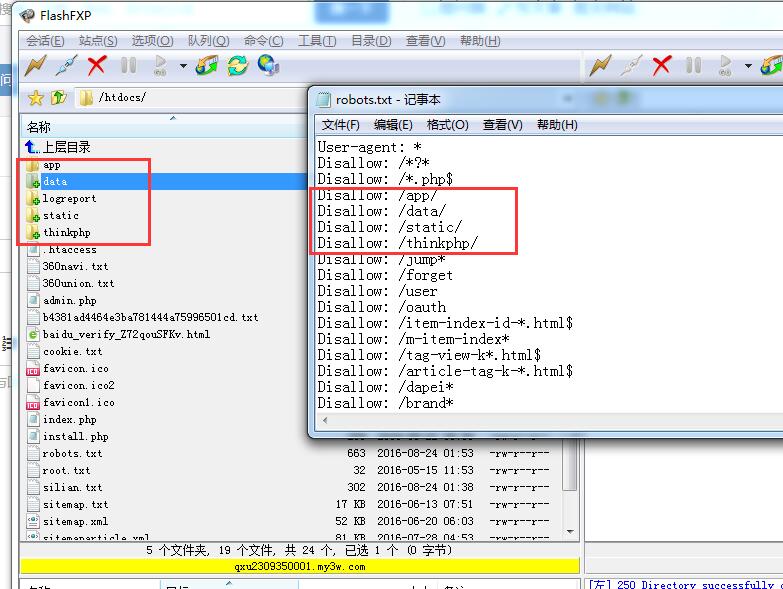

我网站更目录共有五个文件夹(app、data、logreport、static、thinkphp),其中有四个都在robots里面禁止了,只有logreport文件夹没有被禁止,但是logreport里面也没什么东西,这种情况是不是意味着把整个网站都给禁止抓取了?

如果都给禁止抓取了,为什么百度还会收录首页、栏目页和文章?

首先你得明白源码目录路径与前台解析过的HTML路径是不一样的

如果你想屏蔽全站的的话,最简单方法,这样写就行了

User-agent: *

Disallow: /

不知道怎么写。看看这个就行。很详细

只是限制了抓取 APP、data、logreport、static、thinkPHP这几个目录而已,并不是全部限制,你的文章列表、商品详情页、文章页又不在这几个目录中,并没有被禁止,当然会被抓取和收录。例如:www。你的域名。com/,这个url的结构并不属于以上任何目录。

###只要Robots没有全部禁止蜘蛛爬行,首页肯定收录的啊,你这个文件写法有点多了,只要不涉及内部的,抓取就可以了。

###多了解一下 Robots写法的具体规则你就明白啦,Site网站都是收录的,那肯定就是没禁止啊

###这种情况你只是针对五个目录而已,如果你禁止四个目录,百度当然遵循Robots协议屏蔽掉,但是,有些栏目虽然robots屏蔽,百度还收录原因是这个栏目有外链,百度顺着外链找到你栏目当然照收不误!淘宝站是个例子。

###Disallow是指不希望被访问的一组URL进行,记住是URL,不是什么路径,目录,整个Robots也是针对URL来去做处理的!希望能给你有帮助!

###虽然你文章是放在5个文件夹下的,但是URL格式是在根目录下的资讯,并非目录下。因此还是会抓取。

###你这是限制了这几个目录和动态地址,其他的没有限制

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/42975.html