[导读]:最近一周百度突然不收录我网站的最新文章,我开始是因为收录有延迟了,但今天查看了日志,发现蜘蛛90%的精力在抓取错误的目录,不存在的目录,而这些现象我在一个多月前...

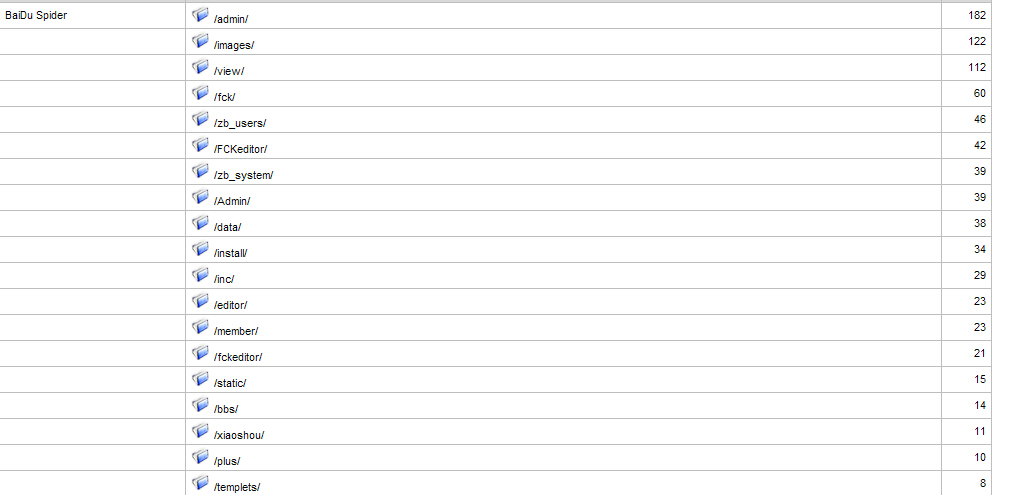

最近一周百度突然不收录我网站的最新文章,我开始是因为收录有延迟了,但今天查看了日志,发现蜘蛛90%的精力在抓取错误的目录,不存在的目录,而这些现象我在一个多月前遇上过,已经在robots.txt封禁了,本来蜘蛛没抓取了,可是我又没改过robots.txt,但现在不知道为什么蜘蛛又在抓取。好奇怪,不知道怎么回事呢。

Robots现在根本就屏蔽不了,我也不知道什么原因造成,我记得以前,放在robots里面的链接,一个星期后左右是可以屏蔽的,除了百度数据更新的时候,会漏放几个。其他还可以的。

1、最好提交死链接,提交死链接要求返还404代码,否则后续的链接不会全部处理,提交死链接后不要在robots中进行屏蔽,否则百度抓取不了。

2.遇到数据大更新了,以往的旧数据会持续的翻出来,这是robots和死链接文件都无法解决的。

3.你的百度spider是否是真实的,DOS命令,nslookup反查。

4.我的建议是能用死链文件用死链文件,robots主要不是用来处理死链文件的。

5.在Site排序页面查询是否有收录的快照,提交申诉

4.以上方法处理后,在观察一段时间看看

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/34520.html