robots文件都设置了,为什么百度依然在抓取我所屏蔽的那些文件。

基本上全在抓取这些东西,根本就没有去抓取站内的文章,让我很是蛋疼纠结啊。

难道我设置的robots方式不对,但我用百度站长工具设置的,是正确的啊。

请教一下,这种情况我到底该怎么处理解决啊?

谢谢夫唯老师邀请

百度蜘蛛抓取的user-agent是:

Mozilla/ (compatible; Baiduspider/ +)

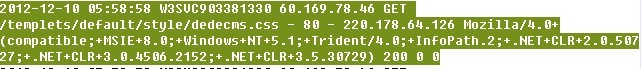

题目中的截图应该是用户访问的记录,而不是蜘蛛爬行的记录。

如果确定有蜘蛛爬行已经屏蔽的路径的话,建议重新放一下截图。

不过Robots屏蔽了,还显示抓取的话,那么要看一下robots文件有没有被抓取,一般生效时间会有一个延迟。

一句话解释的事情:

“如果robots屏蔽的网页、文件被其他页面所链接,那么spider照样会抓取,筛选,建立索引!”

###只能说见怪不怪,纠结久了就不纠结了。

大家的回答已经很详细了,不再赘述。

在此我只想说一个事实:

我们公司拥有自己网站的spider Site 系统,能检测任何spider在我们网站的一切行为,从长期数据来看,尤其是baidu spider有太多不可理解的行为,上述的robot里屏蔽但依然抓取是最正常不过的一个现象而已。

简单分享其他几种baidu spider crawl最常见的现象:

1〉spider crawl网站上没有入口的重复页面比crawl 其有大量入口的原始页面的频率及次数要高很多。

2〉一段时间内百度收录急剧减少百度spider crawl急剧增加,当然这跟页面质量有很大关系,不过仔细分析还是会有无法理解的地方

3〉一类页面其中一部分页面下线之后变为模板统一的内容也就几个字的页面,但是这些下线的页面比在线的页面内容丰富的同类型页面baidu spider crawl量要高很多

4〉spider会为网站URL自动加上参数

......

如果是对比几大搜索引擎的spider数据,问题会更多,很多seo理论在数据面前根本站不住脚。

至于上述屏蔽后spider继续抓取的问题该怎么解决,本人感觉没什么好办法,很多时候类似的问题针对google会有很好的解决办法,针对百度,问题出来之后采取什么办法都不怎么好解决(当然也由于自身水平及其有限),除非在建网站的时候充分考虑到相关因素然后去避免。

以上个人浅见仅供参考。

截图,没有看到有百度蜘蛛抓取的行为。

百度蜘蛛也好奇,你什么文件不让它抓取,排查一下有木有作弊的嫌疑。

它只是看看而已,不紧张,它不会放出来的。

百度官方声明过:大楷意思是,即使设置了Robots,如果抓取的URL在其他地方有出现,百度依然会抓取、索引,这点赞同@白浩波 。

有个缓存期了,不要担心,很快就会不抓取的!!

###需要一定的时间响应,不着急,百度在细节上的处理 还不是那么完美!

###1、夫唯老师说的这个时间问题

2、他会从一些站外链接锚文章爬过来

虽然做了,Robots,并不代表搜索引擎不去索引你的网站,他会去抓取,但不会出现在搜索结果中,robots.txt协议并非是一个标准,一个规范,只是约定俗成而已罢了,通常搜索引擎会识别这个文件,但也有一些特殊情况。 无论是百度亦或是谷歌,某个页面只要有其他网站链接到该页面的话,同样有可能会被索引和收录。要想彻底屏蔽页面文件被谷歌索引的话(即使有其他网站链接到该页面文件),则需要在页面head中插入noindex元标记或x-robots-tag。如下:

当谷歌蜘蛛看到页面上着noindex的元标记,就会将此页从谷歌搜索结果中完全丢弃,无视是否还有其他页链接到此页。

而百度呢?对于百度而言,并不支持如谷歌那般通过noindex完全将网页从索引上删除,仅支持noarchive元标记来禁止百度显示网页快照。具体语句如下:

上面这个标记只是禁止百度显示该页面快照,但百度仍会为其建索引,并在搜索结果中显示网页摘要。

众所周知,淘宝网通过robots.txt全站屏蔽百度蜘蛛,可为什么我们在百度搜索淘宝网时第一个结果也是淘宝网首页地址呢?而在我们查看该页面快照时却是显示空白?因此看来,网站只能禁止百度快照的显示,却无法做到禁止百度为网页建索引。

他这个时间期限挺长。估计要一个月才能确认不再抓取。

但现在他抓取,但不会放出。

NND,这些文件里面文件很多,分析了下日志,我靠,全在抓取这些对网站没什么用的东西,那些文章页面根本都不过去,让哥很蛋疼纠结啊。

百度在怎么厉害,也不能把我当爹抗啊,虽然我不介意。

百度根本就不按Robots文件规则来,反正我是信了,想抓照样抓,我的新站规则上线前就写好了不让抓取的地方,可是禁止的地方照样去抓。

###想想301百度多长时间才能反映过来就能理解了

###Robots 只是第三方协议 搜索引擎可以抓取的 但是不一定会放出来!

###百度用什么形容呢?

反应慢,经常跟不上节奏。

脑袋转不过弯,告诉他怎么做,还是不会。

经常坑爹,做错了事不愿意承担责任。

本文来自投稿,不代表微盟圈立场,如若转载,请注明出处:https://www.vm7.com/a/ask/16523.html